Представьте себе чат с искусственным интеллектом, который работает локально на вашем ПК, задействуя лишь ресурсы системы для ответов на поставленные вопросы. Именно это и представляет собой Chat with RTX от NVIDIA — это текстовый генеративный ИИ, вроде ChatGPT или Copilot, с внушительным набором возможностей, который в процессе выполнения работы не отправляет на серверы корпораций ни бита данных. Кроме того, утилита позволяет пользователю выбирать оптимальную для конкретной задачи большую языковую модель (на текущий момент доступны Llama2 и Mistral), и, что самое удивительное, это всё работает бесплатно. Но насколько хорошо справляется Chat with RTX? Самое время выяснить.

Как установить Chat with RTX на ПК

Для того, чтобы использовать чат-бота на базе ИИ локально на своём ПК, нужно сначала загрузить десятки гигабайт данных — соответственно, сначала нужно перейти на официальный сайт NVIDIA и загрузить установщик весом в 35 ГБ. Это ZIP-архив, внутри которого находятся сжатые файлы (включая большую языковую модель) — после распаковки нужно лишь запустить исполняемый файл, и программа будет установлена (на это нужно какое-то время).

Системные требования Chat with RTX

- Видеокарта RTX 30 или RTX 40 с 8 ГБ видеопамяти.

- 100 ГБ пространства на накопителе (предпочтительно на SSD, так как на HDD установка проходит слишком долго).

- Windows 11 или Windows 10.

- Последняя версия драйвера NVIDIA (535.1 и новее).

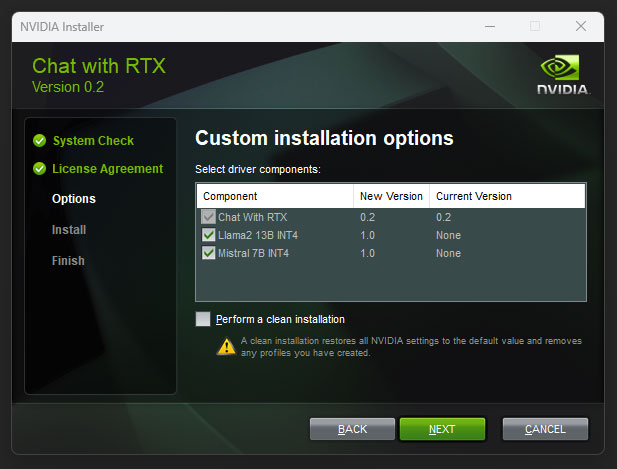

Процесс установки Chat with RTX максимально простой и визуально напоминает установку драйверов GeForce. В процессе установки приложение загрузит дополнительные компоненты, которые необходимы для работы чат-бота. Например, нужно будет скачать компоненты, связанные с Python и Anaconda. В результате в памяти ПК текущая версия Chat with RTX будет занимать примерно 69 ГБ пространства — 6,5 ГБ уходят на среду Anaconda, основанную на базе Python, большие языковые модели LLama2 и Mistral занимают 31 и 17 ГБ соответственно, плюс система установит дополнительные библиотеки для Python (10 ГБ).

Стоит отметить, что владельцам видеокарт с 16 ГБ видеопамяти и более, программа установки предложит загрузить обе модели искусственного интеллекта — Llama2 и Mistral. Тем, у кого 8 ГБ или 12 ГБ видеопамяти, приложение предлагает установить только Mistral. Это связано с тем, что модель Llama2 и её набор данных занимают огромный объём видеопамяти. Данное ограничение можно отменить, отредактировав файл конфигурации программы установки, который расположен во вложенной папке исполняемого файла программы (впрочем, работоспособность такой конфигурации ещё стоит изучить).

По завершению установки программа разместит на рабочем столе ярлык для запуска приложения. В случае, если по каким-то причинам ярлык не был создан, а запуск приложения вы отменили, найти исполняемый файл можно в папке AppData по адресу:

- %LOCALAPPDATA%\NVIDIA\ChatWithRTX\RAG\trt-llm-rag-windows-main\app_launch.bat.

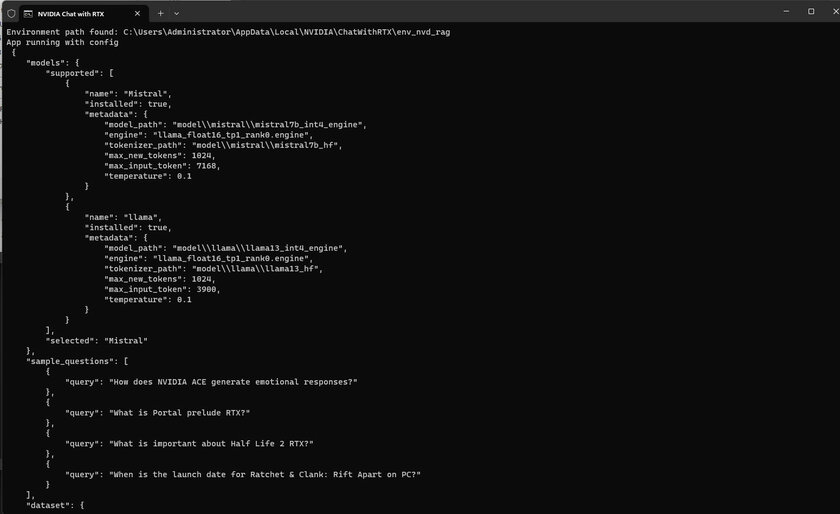

После запуска данного файла система запустит окно CMD Shell и загрузит необходимые данные — это занимает примерно минуту времени. В процессе утилита выделяет 6-8 ГБ видеопамяти вашей видеокарты для работы больших языковых моделей, так что игры лучше не запускать, а вот с YouTube проблем не возникло. Окно CMD Shell должно быть запущено в фоновом режиме, поскольку именно в нём выполняются все работы с сервисом Chat with RTX, а интерфейс приложения представлен окном в браузере.

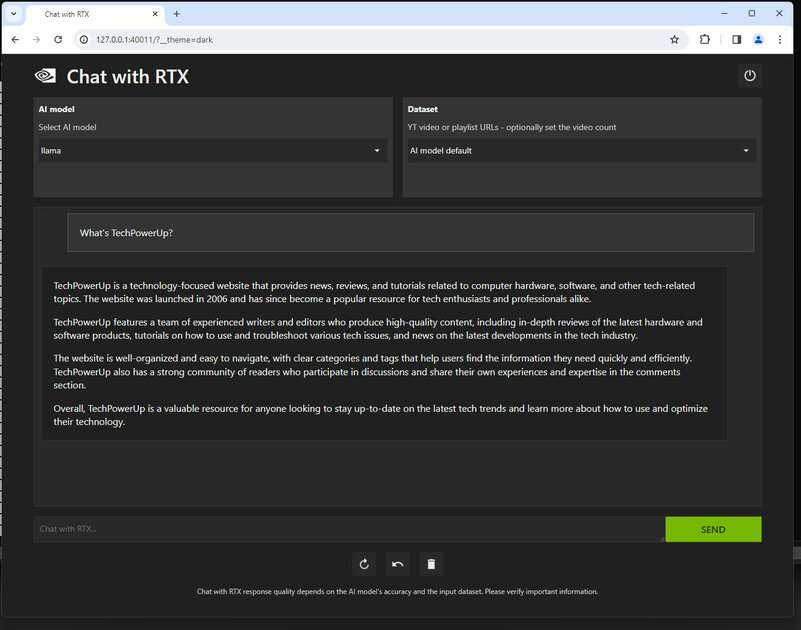

Соответственно, после запуска службы нужно в адресной строке браузера указать 127.0.0.1:1088/?__theme=dark, после чего будет запущена фронтенд-часть приложения (номер порта отображается в окне CMD Shell после запуска).

ИИ, который можно обучать самостоятельно

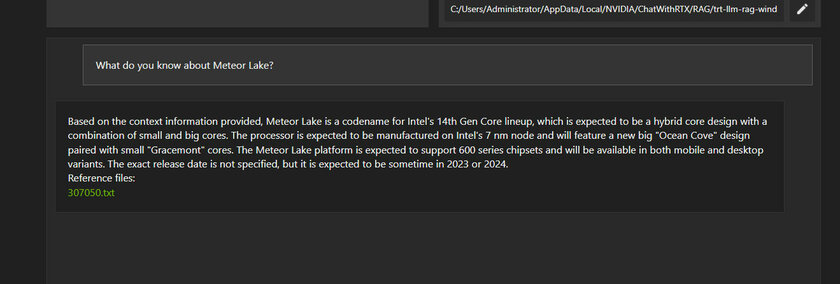

По умолчанию Chat with RTX позволяет задавать вопросы о функциях и возможностях чат-бота, плюс в выпадающем списке можно выбрать большую языковую модель, которую нужно использовать. На старте пользователь получает модель ИИ с набором данных, обновлённых по состоянию на середину 2022 года, объёмом примерно 16-17 ГБ, так что пространства для работы предостаточно. Но, безусловно, наборы этих данных не такие полные, как у GPT 3.5, а ответы не настолько тщательно проработаны, как в ChatGPT. Но это не так важно, потому что у NVIDIA есть козырь в рукаве — он заключается в том, что Chat with RTX умеет получать любые данные в виде .txt-документа (а также форматах Word и PDF), чтобы на их основе обучаться.

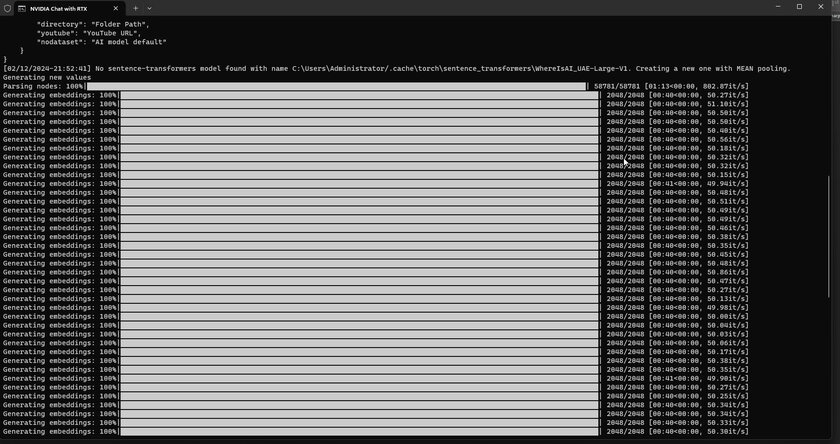

В процессе теста мы «скормили» ему все новостные статьи, которые когда-либо публиковались на нашем сайте, и это потребовало немалой работы. Нужно было экспортировать все новости в текстовые файлы и в итоге у нас получилось 250 МБ текстового контента или примерно 60 тысяч статей. Приложению потребовалось около часа на RTX 4080, чтобы языковая модель LLama2 смогла обучиться на этих данных, и в конечном итоге чат-бот начал отвечать на вопросы, связанные с компьютерным железом или технологиями.

Насколько качественно это работает

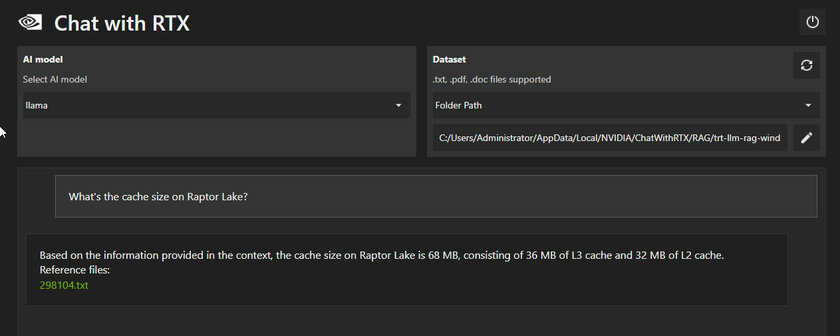

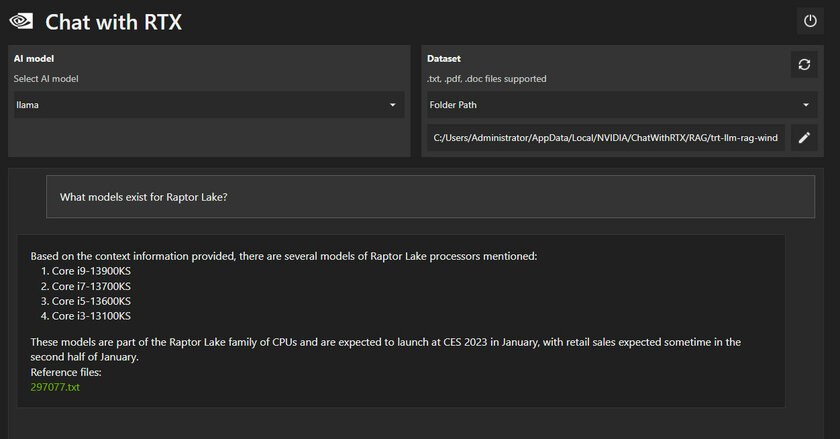

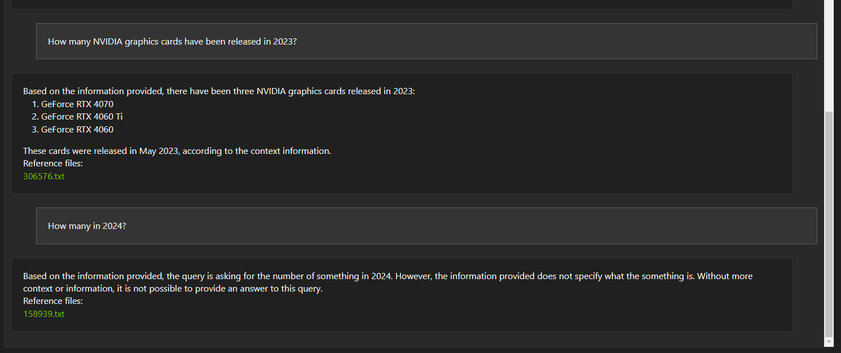

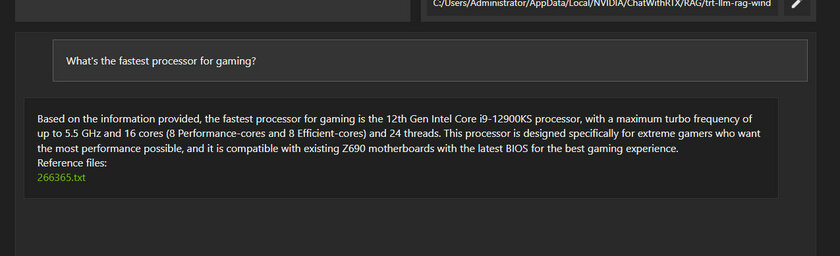

После того, как мы обучили Chat с RTX на наших 60 тысячах новостей и статей, мы начали тестировать чат-бота — но при этом ни один из наших вопросов не был специально составлен так, чтобы вызвать у ИИ какие-то трудности. Например, мы спросили о количестве кэша у процессоров Intel поколения Raptor Lake — довольно туманный вопрос, особенно если учесть, что мы не указали конкретную модель процессора. Чат-бот выдал ответ: «Согласно информации, представленной в контексте, объём кэша в Raptor Lake составляет 68 МБ, состоящих из 36 МБ кэша L3 и 32 МБ кэша L2». Это верный ответ (для процессора Intel Core i9-13900K), плюс в конце чат-бот прикрепил ссылку на файл, из которого была получена эта информация. Вероятно, ИИ не просто копирует утверждение из новости, а составляет ответ в формате естественного языка, основываясь на полученной информации.

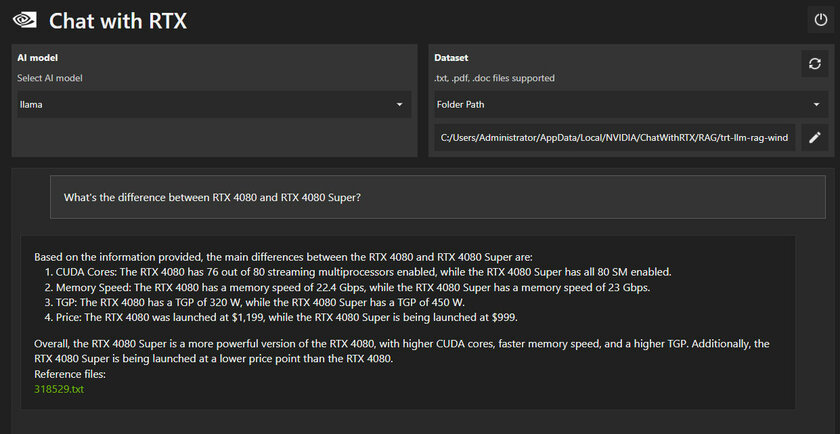

Также мы спросили у чат-бота о том, чем отличается RTX 4080 Super от оригинальной RTX 4080 2022 года. Большая часть информации из ответа верна, но TGP в 450 Вт указан неверно. В нашей публикации чётко указано, что это теоретический предел конфигурации кабеля, а не фактический предел мощности видеокарты. И хотя на первый взгляд ответы выглядят правдоподобно, на деле информация не имеет никакого смысла для читателя, разбирающегося в вопросе. И это одна из главных опасностей таких текстов, сгенерированных искусственным интеллектом.

Кроме того, в текущем состоянии Chat with RTX не может связать одни вопросы с другими — здесь нет хронологии. Впрочем, об этом прямо говорит NVIDIA, так что это не стало неожиданностью.

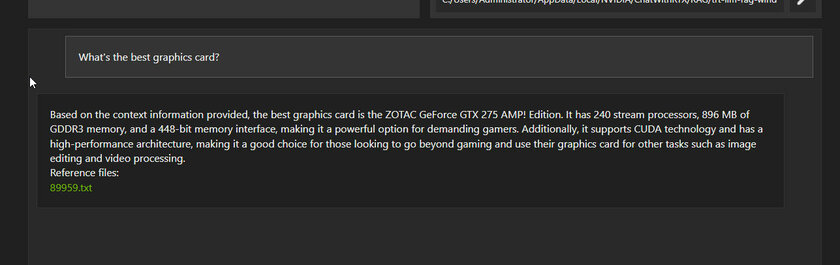

Но когда мы начали задавать вопросы, которые могут встречаться в реальной жизни, эффективность чат-бота оставляла желать лучшего. К примеру, на вопрос «Какая лучшая видеокарта для игр?» ИИ ответил «ZOTAC GeForce GTX 275 AMP! Edition». Да и некоторые другие ответы откровенно неправильные, хотя текст выглядит вполне правдоподобно.

Интересной функцией приложения Chat with RTX является возможность «смотреть» ролики на YouTube и отвечать на поставленные вопросы по контенту из видео. Нужно лишь ввести ссылку на ролик или на целый плейлист, после чего приложение индексирует данные и может отвечать на вопросы.

Это впечатляет, но на самом деле всё работает немного не так — когда пользователь даёт ссылку на ролик, система ищет англоязычный файл с титрами, который предоставляет сам YouTube, после чего обучается на текстовом контенте и отвечает на вопросы по нему. Здесь нет никакой магии — приложение не «просматривает» видеопоток и не «слушает» аудио, не распознаёт изображения и не трансформирует речь в текст. Чат-бот просто отвечает на вопросы по текстовому файлу, загруженному с YouTube. Но, конечно, это всё равно фантастическая идея, которая значительно упростит восприятие информации в длинных видео, особенно в случае с подкастами.

Отзыв

Chat с RTX впечатляет своим потенциалом — чат-бот умеет работать не только со встроенными датасетами Llama2 и Mistral, но и практически с любой информацией. Например, вы можете скачать всю информацию из «Википедии» и получать от ИИ ответы на любые свои вопросы — для школьников или студентов это огромное преимущество. Кроме того, что немаловажно, этот чат-бот работает автономно — он выполняет задачи даже без интернета и не отправляет ваши данные на серверы крупных компаний. Это очень важный момент, потому что обычно пользователи вынуждены доверять свои конфиденциальные данные «облаку», что потенциально может привести к утечке очень ценных данных, да и никто на самом деле не знает, как именно будут использоваться его данные.

Впрочем, мы сильно сомневаемся, что чат-бот будет невероятно популярным за пределами аудитории техногиков. Даже с упрощённым интерфейсом текущая версия утилиты слишком сложна для обычного пользователя — в этом плане стоит похвалить ChatGPT, который выполняет фантастическую работу, скрывая все сложности от пользователя. Хотя установка Chat с RTX явно проще, чем запуск Stable Diffusion или TensorFlow на локальной машине, и в NVIDIA явно работают над максимально простым пользовательским интерфейсом и понятными настройками. При этом ответы ИИ выглядят достаточно убедительными даже в том случае, если они не соответствуют действительности. Из-за этого существует риск того, что люди начнут верить чат-боту и полагаться на его ответы, не оценивая достоверность информации.

Например, после обучения на технических новостях мы ожидали, что чат-бот станет экспертом в области компьютерного железа, и хотя ответы часто были правильными, иногда ИИ всё же ошибался — при этом его ответы казались верными и были написаны в очень убедительном стиле. Ещё ИИ может не только отвечать на вопросы, но и обобщать данные, создавая краткое описание. Такое умеет и ChatGPT, только вам не нужно отправлять кому-то ваши данные. И, конечно, нам очень понравилось взаимодействие с YouTube — в определённых сценариях это упрощает потребление контента, когда ИИ смотрит видео за вас (на деле он считывает текстовые субтитры, но это шаг в правильном направлении). Так что сейчас, без сомнения, Chat with RTX выглядит слегка недоработанным инструментом, но мы уверены, что со временем чат-бот станет существенно лучше.

Это сжатый перевод обзора TechPowerUp.